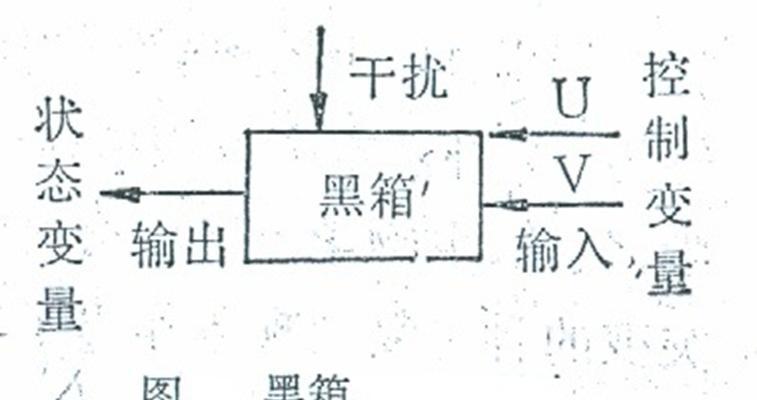

人工智能(AI)已经成为现代科技领域中最令人兴奋的创新之一,但随着其复杂性不断增加,一个被称为“黑箱问题”的问题也逐渐浮出水面。AI黑箱问题是指人工智能模型,尤其是深度学习模型的决策过程不透明,缺乏可解释性。用户或开发者无法清楚地了解模型是如何做出特定决策的,就像一个不透明的黑箱子一样,只知道输入与输出,而无法窥视内部的处理机制。

人工智能黑箱问题的实质

要理解黑箱问题,我们需要先认识到AI模型,特别是深度学习模型的运作机制。这些模型通常包括多层次的神经网络,每一层都会对输入的数据进行复杂的变换和抽象。模型通过在海量数据上进行训练,逐步调整内部参数以最小化预测误差。然而,这种学习过程往往涉及数以百万计的参数,使得它们的决策过程难以被人类直接理解。

为什么需要解决黑箱问题

黑箱问题的存在对于许多应用场景来说,可能引发一系列问题:

1.可解释性缺乏:在某些领域,例如医疗诊断、金融风险评估,可解释性是至关重要的。模型的决策需要透明,以便用户可以理解和信任结果。

2.合规性问题:一些法规要求算法决策过程可审计和可解释,比如欧盟的通用数据保护条例(GDPR)。

3.错误诊断:无法理解模型决策过程可能导致难以诊断和修正模型的错误,从而影响其性能。

解决人工智能黑箱问题的方法

1.模型简化

简化模型结构,如使用线性模型代替复杂的非线性模型,可以提高可解释性。但是这种方法可能会牺牲模型的性能。

2.特征重要性评估

利用各种统计方法评估输入特征对于模型输出的重要性。在随机森林算法中,可以通过计算特征在树中的平均不纯度减少来评估其重要性。

3.可视化技术

对于复杂的神经网络,可以使用可视化技术帮助理解模型内部的工作机制。特征激活映射(FeatureActivationMapping)可以直观显示哪些区域影响了模型的决策。

4.模型解释性工具

开发专门的解释性工具,如LIME(局部可解释模型-不透明模型解释)和SHAP(SHapleyAdditiveexPlanations),可以帮助解释单个预测。

5.增加透明度和文档记录

确保AI模型的开发和部署过程有详细的文档记录和透明度,以方便复审和理解模型的行为。

6.法规与道德框架

建立相应的法规和道德框架,为AI模型的透明度和可解释性提供标准化的指导。

结语

人工智能黑箱问题并非无解。通过模型简化、特征重要性评估、可视化技术、解释性工具、透明度增强和制定相关法规等措施,我们可以逐步提高人工智能模型的可解释性。这不仅有助于增强用户对AI系统的信任,还能提升AI在各个领域的应用价值和安全性。通过持续的研究和实践,我们可以期待AI在透明度和可解释性方面取得更大的进展。

标签: #什么